Apple plant Gestenerkennung durch Künstliche Intelligenz

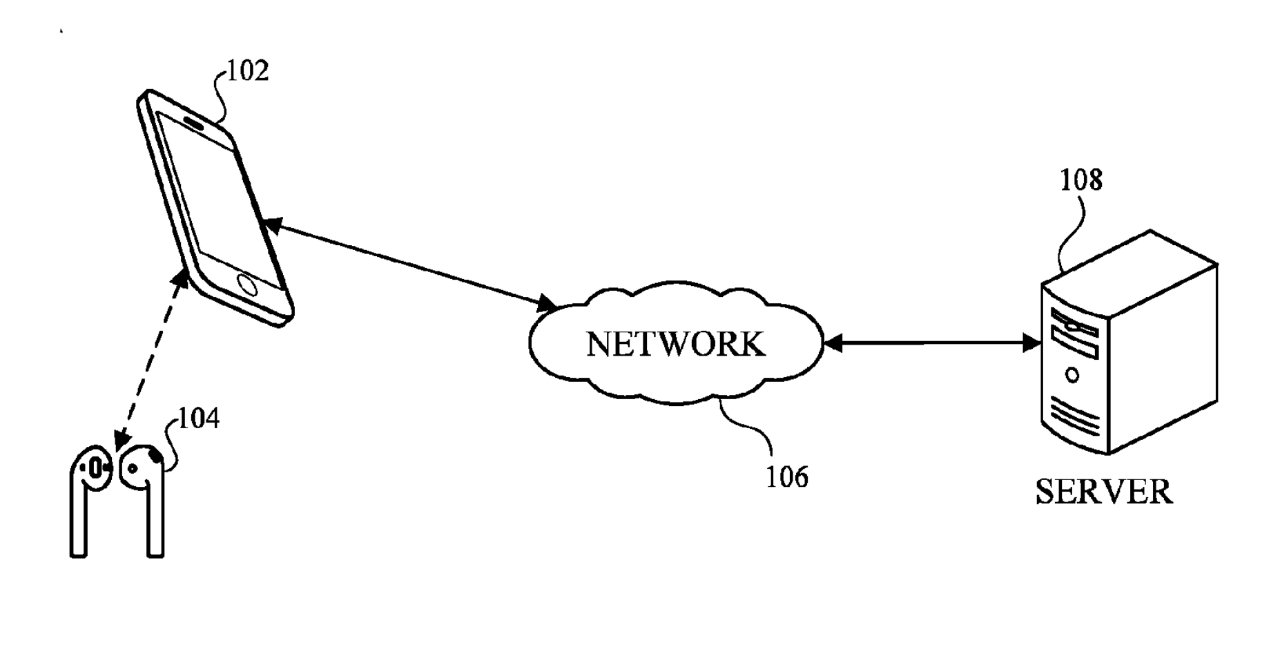

In einer kürzlich gewährten Patentanmeldung plant Apple, zukünftige iPhones oder AirPods so zu gestalten, dass sie Benutzerbewegungen durch maschinelles Lernen beobachten und erlernen können. Dadurch könnte das Wischen auf jedem Gerät oder jeder Oberfläche eine Reaktion wie das Hoch- oder Herunterdrehen der Lautstärke auslösen.

Eine virtuelle Berührungsschnittstelle

Apple stellt sich eine Zukunft vor, in der Geräte vorgeben können, berührungsempfindliche Steuerungen zu haben. Obwohl dies für jedes Gerät gelten könnte, betont Apple die Anwendung auf Earbuds, wo dies eine Lautstärkeregelung bedeuten könnte, wo es keine gibt.

Der Titel des Patents lautet “Machine-Learning Based Gesture Recognition”. Apple plant hierbei, Geräte wie tragbare Ohrhörer mit weiteren Sensoren, wie optischen oder Näherungssensoren, möglicherweise auch Temperatur- oder Bewegungssensoren, auszustatten.

Einschränkungen und Möglichkeiten

Gemäß Apple könnten Ohrhörer und/oder Kopfhörer aufgrund von Größen-/Platzbeschränkungen, Strombeschränkungen und/oder Herstellungskosten keinen Berührungssensor zur Erkennung von Berührungseingaben und/oder -gesten enthalten. Diese Einschränkung soll Apple jedoch nicht aufhalten.

Es könnte wünschenswert sein, Geräten, die keine Berührungssensoren enthalten, wie Earbuds, die Erkennung von Berührungseingaben und/oder -gesten von Benutzern zu ermöglichen. Dieser Vorschlag ermöglicht es einem Gerät, das keinen Berührungssensor hat, durch die Nutzung von Eingaben über einen oder mehrere Nicht-Berührungssensoren im Gerät, Benutzerberührungen und/oder -gesten zu erkennen.

Kombination von Sensoren

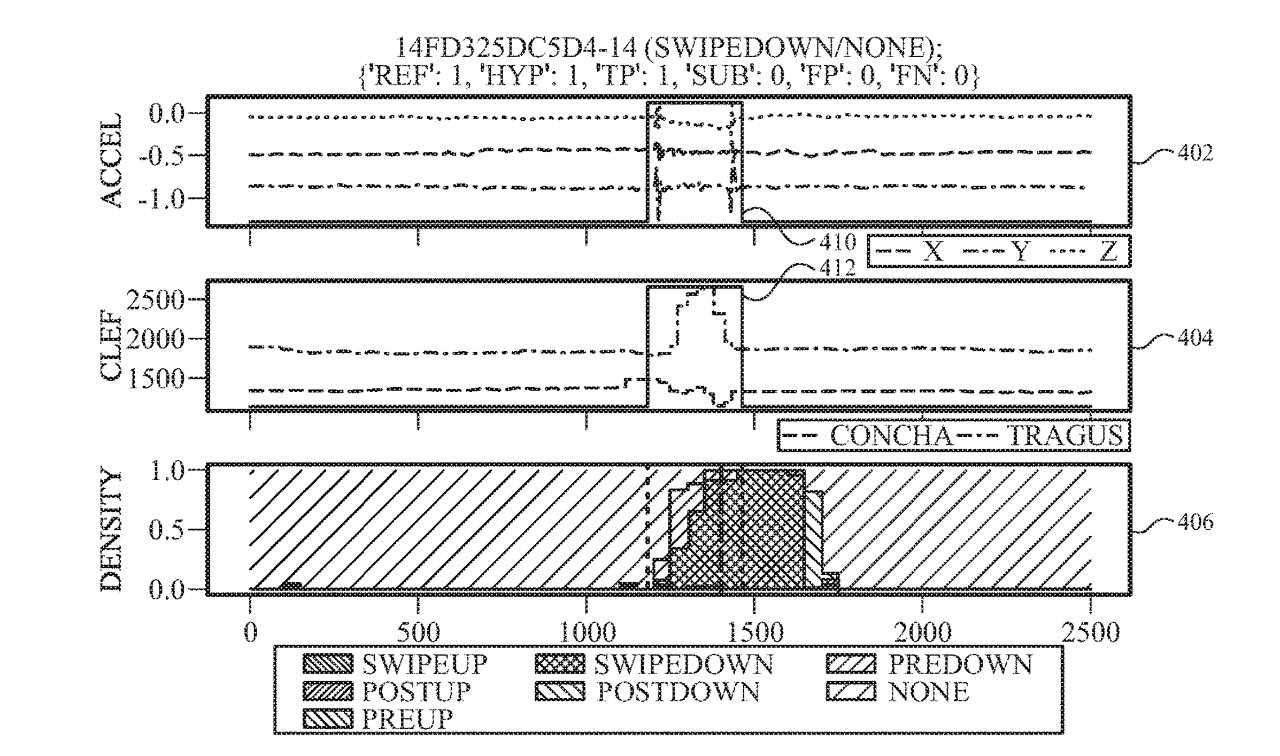

Die Verwendung mehrerer Sensoren in Kombination ist ein zentraler Punkt in Apples neuem Patent. Die Sensoren könnten Gerätebewegungen, biometrische Informationen des Benutzers, Schall, Licht, Wind und generell jede Umgebungseinfluss erkennen. Apple geht so weit zu sagen, dass eine Kombination aus optischem Sensor, Beschleunigungsmesser und Mikrofon einzeln oder gemeinsam eine Berührung anzeigen könnte.

Maschinelles Lernen in Aktion

Das maschinelle Lernen könnte nach einer Trainingsphase einen Satz von Ausgabevorhersagen erzeugen, die zu vorhergesagten Gesten passen. So könnte ML lernen, dass ein Kratzgeräusch am Mikrofon allein nicht ausreicht, aber wenn das Licht in einen optischen Sensor blockiert ist, passiert etwas.

Die Vorhersagen könnten dann eine Richtlinie anwenden, um zu bestimmen, ob eine Aktion für das drahtlose Audioausgabegerät angezeigt werden soll. Wenn ML denkt, dass eine Änderung in, sagen wir, drei Sensoren, signifikant ist, kann es das an die Software weitergeben. Die Software könnte dann zum Beispiel die Lautstärke auf einem Gerät erhöhen oder verringern.

Zukünftige Anwendungen

Wenn ML aus allen Sensoren in einem Gerät lernen kann, könnte es sicherlich auch von jedem Gerät lernen, das ein Benutzer hat. Wenn beispielsweise ein AirPod einen bestimmten Ton erkennt, die Apple Watch jedoch nicht, dann findet dieser Ton neben dem Earbud statt. Es ist daher viel wahrscheinlicher, dass der Benutzer etwas mit dem AirPod tun möchte.

An dieser Erfindung waren acht Erfinder beteiligt, darunter Timothy S. Paek, der zuvor für Apple daran gearbeitet hat, Siri Notizen machen zu lassen, während Sie telefonieren.